Le SEO ne s'arrête pas à Google

23/10/2020

Guillaume Briday

Développement Back

%201.jpg)

On entend souvent qu’il faudrait adapter le référencement naturel au moteur de recherche Google. En effet, Google est indéniablement en position dominante sur le marché des moteurs de recherche, mais il n’est pas le seul. Google met en place un certain nombre de technologies et de critères pour référencer les sites de plus en plus efficacement.

On peut alors tomber facilement dans le piège de mettre en place ou de suivre des pratiques de SEO uniquement optimisées pour Google et oublier tout le reste.

On va voir comment et surtout pourquoi il faut éviter cela.

Google, ses règles et ses solutions

Sur sa plateforme, le géant américain dicte ses lois. Le traitement qui est effectué pour retourner les informations en fonction des mots clés aux utilisateurs n’est pas connu. Il est même très bien gardé. En revanche, on peut émettre des hypothèses sur son fonctionnement et essayer de bouger des variables d’ajustement et voir les effets quelque temps plus tard sur les pages de résultats.

L’algorithme évolue perpétuellement dans le but de rendre les résultats toujours plus pertinents pour les utilisateurs, mais aussi et surtout pour augmenter la rentabilité du moteur de recherche. On le voit avec la mise en avant de plus en plus marquée des contenus payants en première page. C’est ce qu’on appelle le SEA (Search Engine Advertising).

Le nombre d’éléments à prendre en compte pour être le mieux référencé possible augmente naturellement en fonction des mises à jour de l’algorithme. On le remarque depuis quelque temps, le moteur de recherche est très sévère dans l’appréciation de ces règles et il faut savoir s’adapter très vite. Pour le meilleur et pour le pire. Ainsi, si un site ne s’occupe pas régulièrement de son SEO, il perdra forcement des points et descendra ainsi dans la liste des sites référencés.

Avec les nouvelles technologies et procédés pour faire des sites Web, Google a aussi dû s’adapter.

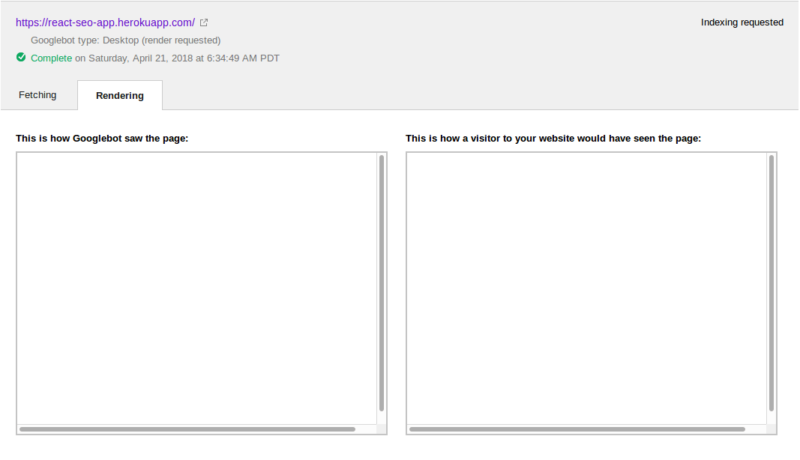

Vous en avez peut-être déjà entendu parler, mais les frameworks JavaScript tel que Vue.js ou React sont des outils qui ont le vent en poupe. Malheureusement, par défaut, la nature de ces technologies font qu’elles sont invisibles pour Google ou tout autre outil qui essayerai d’en récupérer le contenu.

C’est à la charge du développeur de mettre en place une solution de contournement pour pouvoir utiliser ces technologies et ainsi pouvoir être vu par tous les outils qui ont besoin d’accéder au site Web. En effet, le contenu d’une page avec ces outils, n’est disponible qu’après le premier chargement dans votre navigateur. Si un robot n’est pas capable de simuler automatiquement un navigateur et d’exécuter le contenu de la page, il verra une page blanche.

Google a dû mettre en place le moyen de pouvoir interpréter ces outils pour pouvoir les voir. Il n’y a pas beaucoup d’entreprises qui ont les moyens technologiques et financiers de mettre en place une telle prouesse. Malheureusement, Google fait partie des seuls à l’avoir fait et les résultats ne sont pas encore parfaits.

Les réseaux sociaux changent la donne

Avant l’explosion des réseaux sociaux, le principal point d’entrée sur un site était effectivement un moteur de recherche, plus généralement Google. Aujourd’hui les choses ont bien changé et il n’est pas rare de voir des entreprises ou des sites Web qui ne communiquent plus que par les réseaux sociaux. Ainsi la place du moteur de recherche a fortement diminué dans les dernières années. Selon la typologie du site, il n’est désormais plus forcément indispensable d’être visible en première page du géant Américain.

Les règles pour être visible sur les réseaux sociaux

Cela n’empêche pas qu’il faut quand même être visible lorsque l’on publie un lien sur les réseaux sociaux. Il faut aussi respecter des règles de base comme la bonne utilisation des Meta Tags, avoir de bons titres et de bonnes descriptions, avoir un bon maillage de liens, un sitemap, etc.

Sur Google il y a beaucoup de paramètres qui sont pris en compte comme la vitesse du site, son utilisabilité en mobile, à quel point le contenu semble être naturel, éviter le contenu dupliqué, etc. Lorsque l’on est référencé sur Google, on veut rester en première page et le rester longtemps. Sur les réseaux sociaux en revanche, le contenu est beaucoup plus temporaire.

Il faut marquer les esprits vite et fort et être partagé le plus de fois possible et pour avoir de la visibilité.

Les réseaux sociaux n’indexent pas votre site, ils se basent uniquement sur les données qu’ils peuvent récupérer lorsque vous partagez un lien. Il est ainsi indispensable de respecter toutes les règles ci-dessus pour qu’il soit correctement visualisé.

En parlant des réseaux sociaux, avez-vous vu notre Instagram ?! 😁

Conclusion

Avant de partager un lien sur les réseaux sociaux, vous pouvez tester à quoi cela ressemblera avec https://metatags.io.

Le référencement naturel n’est pas simple, il faut jouer à un jeu auquel on ne connait pas les règles alors qu’elles évoluent tous les jours. L’objectif est désormais de trouver un juste milieu entre les moteurs de recherche classiques et les réseaux sociaux en fonction du secteur et de l’axe de communication mis en place. Il faut contrôler les résultats régulièrement et adapter sa stratégie au jour le jour pour être efficace.

Pour continuer la lecture